Dans ce blog, nous nous concentrerons sur les façons dont vous pouvez augmenter l'utilisation du GPU dans PyTorch.

Comment augmenter l’utilisation du GPU dans PyTorch ?

Plusieurs techniques peuvent être utilisées pour augmenter l'utilisation du GPU et garantir que les meilleures ressources matérielles sont utilisées pour le traitement de modèles d'apprentissage automatique complexes. Ces tactiques impliquent la modification du code et l'utilisation des fonctionnalités de PyTorch. Quelques trucs et astuces importants sont répertoriés ci-dessous :

- Chargement des données et tailles de lots

- Modèles moins dépendants de la mémoire

- Foudre PyTorch

- Ajuster les paramètres d'exécution dans Google Colab

- Vider le cache pour l'optimisation

Chargement des données et tailles de lots

Le ' Chargeur de données ' dans PyTorch est utilisé pour définir les spécifications des données à charger dans le processeur à chaque passage du modèle d'apprentissage en profondeur. Un plus grand « taille du lot « de données nécessitera plus de puissance de traitement et augmentera l'utilisation du GPU disponible.

La syntaxe pour attribuer un Dataloader avec une taille de lot spécifique dans PyTorch à une variable personnalisée est donnée ci-dessous :

Increase_GPU_Utilization = DataLoader ( taille du lot = 32 )

Modèles moins dépendants de la mémoire

Chaque architecture de modèle nécessite un volume différent de « mémoire » pour performer à son niveau optimal. Les modèles qui utilisent efficacement moins de mémoire par unité de temps sont capables de fonctionner avec des tailles de lots bien supérieures à celles des autres.

Foudre PyTorch

PyTorch a une version réduite qui est « Foudre PyTorch ». Il est optimisé pour des performances ultra-rapides, comme son nom l’indique. Lightning utilise des GPU par défaut et offre un traitement beaucoup plus rapide pour les modèles d'apprentissage automatique. L’un des principaux avantages de Lightning est l’absence d’exigence de code passe-partout susceptible d’entraver le traitement.

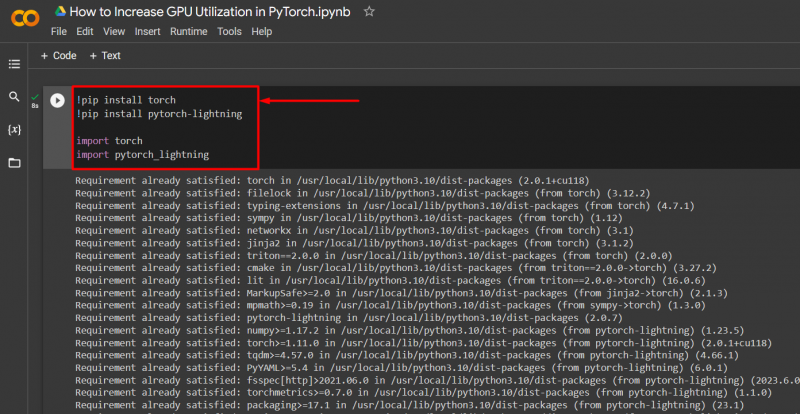

Importez les bibliothèques nécessaires dans un projet PyTorch avec la syntaxe ci-dessous :

! pip installer la torche

! pip installer pytorch - foudre

importer torche

importer pytorch_lightning

Ajuster les paramètres d'exécution dans Google Colab

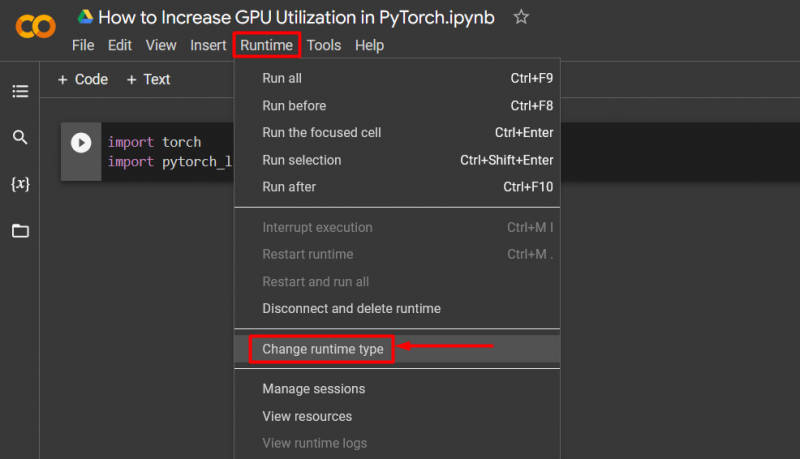

Le Google Colaboratory est un IDE cloud qui offre un accès GPU gratuit à ses utilisateurs pour le développement de modèles PyTorch. Par défaut, les projets Colab s'exécutent sur CPU mais les paramètres peuvent être modifiés.

Ouvrez le notebook Colab, accédez au menu ' Durée ' dans la barre de menu et faites défiler jusqu'à l'option ' Modifier les paramètres d'exécution » :

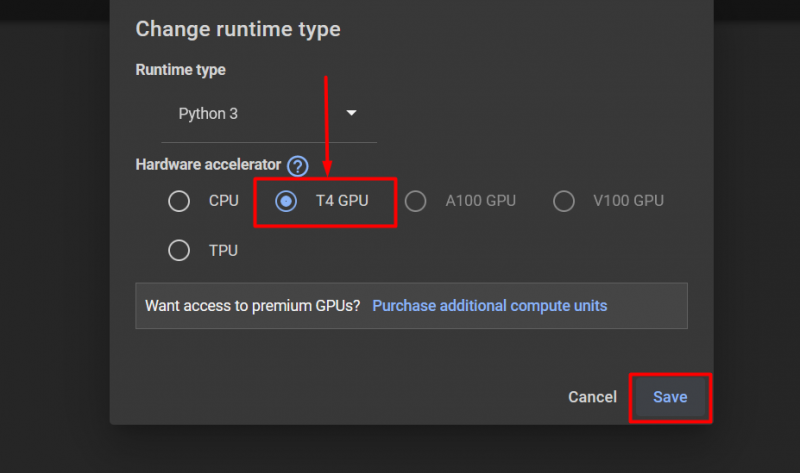

Ensuite, sélectionnez le 'GPU T4' option et cliquez sur « Sauvegarder » pour appliquer les modifications permettant d'utiliser le GPU :

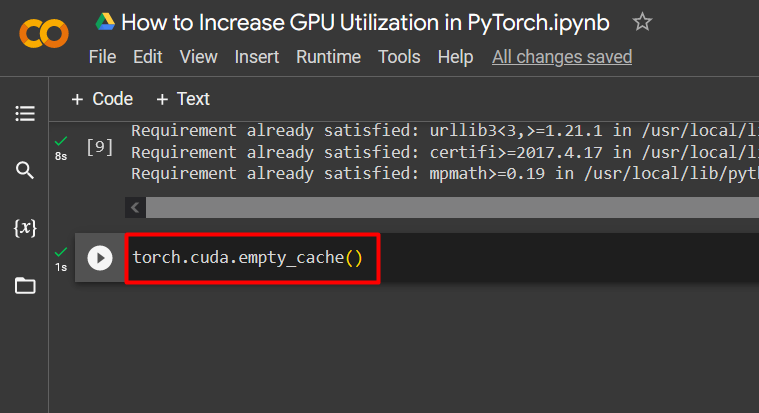

Vider le cache pour l'optimisation

PyTorch permet à ses utilisateurs de vider le cache mémoire afin de pouvoir libérer de l'espace pour l'exécution de nouveaux processus. Le ' Cache ' stocke les données et les informations sur les modèles en cours d'exécution afin de gagner du temps qui sera consacré au rechargement de ces modèles. Vider le cache offre aux utilisateurs plus d'espace pour exécuter de nouveaux modèles.

La commande pour vider le cache GPU est donnée ci-dessous :

torche. différent . cache_vide ( )

Ces conseils sont utilisés pour optimiser l'exécution de modèles d'apprentissage automatique avec des GPU dans PyTorch.

Conseil de pro

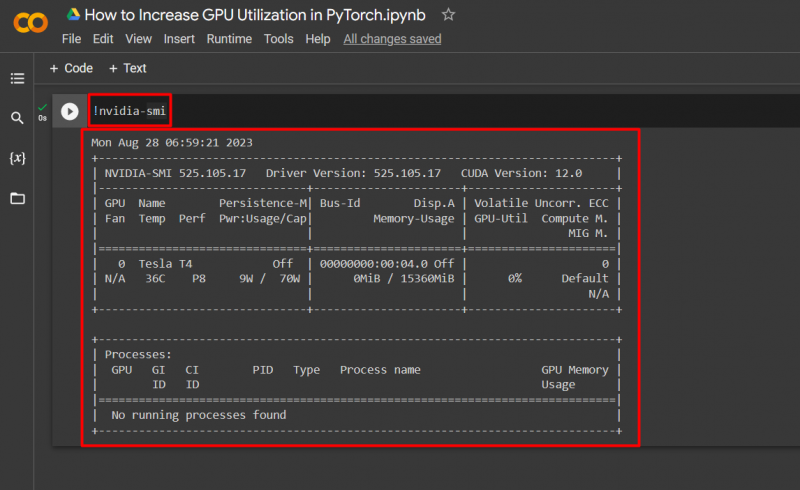

Google Colab permet à ses utilisateurs d'accéder aux détails sur l'utilisation du GPU en « nvidia ' pour obtenir des informations sur l'endroit où les ressources matérielles sont utilisées. La commande permettant de présenter les détails de l'utilisation du GPU est donnée ci-dessous :

! nvidia - smi

Succès! Nous venons de démontrer quelques façons d'augmenter l'utilisation du GPU dans PyTorch.

Conclusion

Augmentez l'utilisation du GPU dans PyTorch en supprimant le cache, en utilisant PyTorch Lightning, en ajustant les paramètres d'exécution, en utilisant des modèles efficaces et des tailles de lots optimales. Ces techniques contribuent grandement à garantir que les modèles d'apprentissage profond fonctionnent de manière optimale et sont capables de tirer des conclusions et des inférences valides à partir des données disponibles. Nous avons démontré les techniques permettant d'augmenter l'utilisation du GPU.