Connaissez-vous le journal d'entrée Get Kubernetes pour le débogage ? Les problèmes de réseau sont de plus en plus difficiles à diagnostiquer à mesure que les déploiements deviennent de plus en plus importants. Ce tutoriel vous montre comment utiliser le plugin ingress-nginx kubectl pour déboguer l'accès à votre application via le contrôleur d'entrée. Voyons d'abord la définition de Kubernetes ingress qui est importante pour mieux comprendre le sujet principal.

Qu'est-ce que l'entrée Kubernetes ?

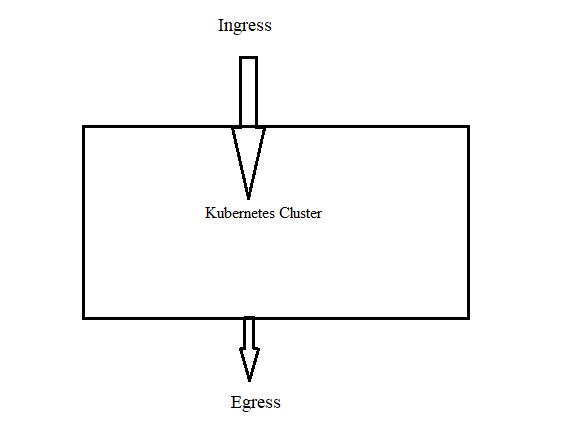

La définition d'ingress est « entrée » dans son sens littéral.

Dans la communauté Kubernetes, c'est également vrai. Un trafic qui entre dans le cluster est appelé entrée, tandis qu'un trafic qui quitte le cluster est appelé sortie.

En tant que ressource Kubernetes native, l'entrée est comparable aux pods, aux déploiements, etc. Vous pouvez suivre les configurations de routage DNS à l'aide de l'entrée. Le contrôleur d'entrée est ce qui effectue le routage. Pour ce faire, il lit les règles de routage directement à partir des objets d'entrée stockés dans etcd. Sans entrée Kubernetes, vous pouvez exposer une application au monde extérieur en incluant un équilibreur de charge de type service dans les déploiements.

Comment fonctionne l'entrée Kubernetes ?

Il y a deux choses essentielles sur lesquelles vous devez être clair. Ceux-ci sont:

Ressource d'entrée Kubernetes

Cette ressource est chargée de maintenir toutes les règles de routage DNS dans le cluster. Les règles de routage DNS sont spécifiées dans la ressource Kubernetes Ingress, une ressource Kubernetes native. En d'autres termes, vous mappez le trafic DNS externe vers les destinations de service Kubernetes internes.

Contrôleur d'entrée Kubernetes

En accédant aux règles DNS mises en œuvre par les ressources d'entrée, les contrôleurs d'entrée Kubernetes (Nginx/HAProxy, etc.) sont en charge du routage.

L'implémentation du contrôleur d'entrée n'est pas native de Kubernetes. Par conséquent, il ne peut pas s'agir d'une valeur par défaut du cluster.

Pour que les règles d'entrée fonctionnent, nous devons configurer un contrôleur d'entrée. Il existe de nombreux contrôleurs d'entrée open source et professionnels sur le marché. La version d'un cluster d'un serveur proxy Web inversé sert de contrôleur d'entrée. Ce serveur proxy inverse basé sur Kubernetes est exposé à un service d'équilibrage de charge.

Qu'est-ce que le contrôleur d'entrée ?

Un programme exécuté sur un cluster appelé Ingress Controller configure un équilibreur de charge HTTP en fonction des ressources Ingress. L'équilibreur de charge peut être un matériel déployé en externe ou un équilibreur de charge cloud, ou il peut fonctionner comme un logiciel au sein du cluster. Différentes implémentations de contrôleur d'entrée sont nécessaires pour divers équilibreurs de charge.

Lors de l'utilisation de NGINX, l'équilibreur de charge et le contrôleur d'entrée sont tous deux déployés dans un pod.

Veuillez noter qu'un contrôleur d'entrée actif doit être présent dans le cluster pour que la ressource Ingress fonctionne.

Les contrôleurs d'entrée ne sont pas automatiquement lancés avec un cluster, contrairement aux autres types de contrôleurs qui fonctionnent comme un composant du binaire kube-controller-manager.

Conditions préalables:

Vous avez besoin d'un cluster Kubernetes et vous devez configurer l'outil de ligne de commande kubectl pour vous connecter à votre cluster. Vous pouvez envoyer les commandes aux clusters Kubernetes à l'aide de l'outil de ligne de commande kubectl. Les applications peuvent être déployées, les ressources du cluster peuvent être inspectées et gérées, et les journaux peuvent être consultés à l'aide de kubectl.

Si vous n'avez pas actuellement de cluster, Minikube peut être utilisé pour en construire un. Minikube est un Kubernetes local qui vise à simplifier l'apprentissage et le développement de Kubernetes.

Kubernetes est accessible avec une seule commande si vous disposez d'un environnement de machine virtuelle ou d'un environnement de conteneur Docker (ou similaire). Commençons maintenant le processus étape par étape :

Étape 1 : Démarrez le Minikube

À l'aide de l'outil minikube, vous pouvez exécuter Kubernetes localement. Minikube exécute un cluster Kubernetes local tout-en-un ou multi-nœuds sur votre ordinateur pour le travail de développement quotidien ou pour tester Kubernetes (y compris les PC Windows, Linux et macOS). Voici la commande pour démarrer le minikube :

> commencer minikube

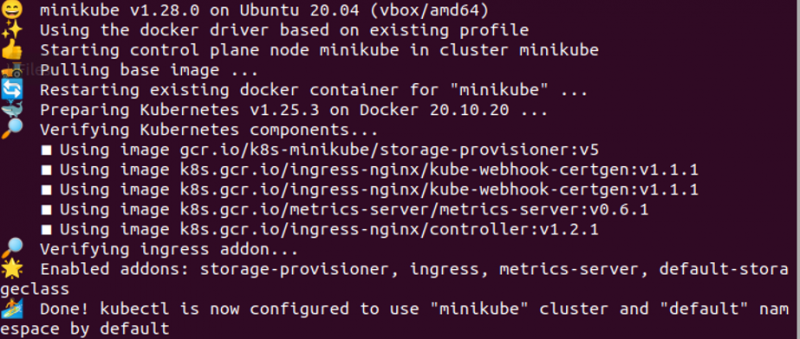

Étape 2 : Activer le contrôleur d'entrée

Nous allons montrer comment activer le contrôleur NGINX Ingress dans cette étape. Exécutez la commande suivante :

> modules minikube permettre entrée

Étape 3 : Vérifiez si le contrôleur d'entrée NGINX fonctionne ou non

Maintenant, il est important de vérifier si le contrôleur NGINX est actif ou non. La commande qui suit peut être utilisée pour confirmer que :

> kubectl obtenir des pods -n entrée-nginx

Sachez que vous ne remarquerez peut-être pas que ces modules fonctionnent correctement pendant une minute. La sortie est affichée dans l'image précédente.

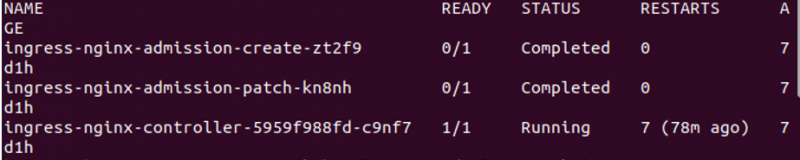

Étape 4 : Créer une application Hello World

Ici, nous utilisons la commande suivante pour créer un déploiement :

> kubectl créer un site Web de déploiement --image =gcr.io / google-samples / bonjour-app : 1.0

La commande qui est exécutée et ses résultats sont joints dans l'image précédente. Dans la sortie, 'hello-app' peut être vu.

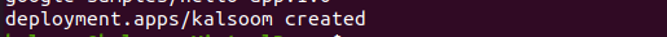

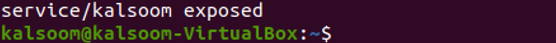

Étape 5 : Exposez le déploiement

Maintenant, nous allons vous montrer une commande pour exposer un déploiement spécifique. La commande est mentionnée comme suit :

> kubectl expose le déploiement Kalsoom - -taper =NodePort --Port = 8080

Vous pouvez voir la sortie « service/kalsoom exposé » dans l'image précédente.

Étape 6 : Visitez le service via NodePort

Il s'agit d'une étape importante où nous vous montrons comment vous pouvez visiter le service créé via le NodePort. La commande pour atteindre cet objectif est donnée dans ce qui suit :

> service minikube Kalsoom --url

La commande ainsi que la sortie sont jointes dans l'image précédente.

Désormais, l'adresse IP Minikube et NodePort simplifient l'affichage de l'exemple d'application. Vous pouvez utiliser la ressource Ingress pour accéder à l'application à l'étape suivante.

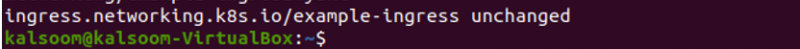

Étape 7 : Créer une entrée

Ici, nous créons une entrée qui transmet le trafic à votre service. La commande est mentionnée comme suit :

> kubectl appliquer -F https: // k8s.io / exemples / un service / la mise en réseau / exemple-ingress.yaml

Comme vous pouvez le voir, la commande est exécutée avec succès.

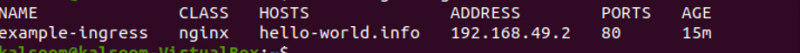

Étape 8 : Vérifiez l'adresse IP

Nous vérifions si l'adresse IP est définie ou non. Pour cela, nous utilisons la commande donnée suivante :

> kubectl obtenir l'entrée

Dans la sortie, vous devriez voir une adresse IPv4 dans la colonne ADDRESS.

Conclusion

Un aperçu de la journalisation du contrôleur d'entrée NGINX est fourni dans cet article. Pour résumer, les journaux d'accès et d'erreurs pour NGINX ainsi que les journaux du processus du contrôleur d'entrée qui crée la configuration NGINX et recharge NGINX pour l'appliquer, sont mis à disposition par le contrôleur d'entrée NGINX.