L'intelligence artificielle est l'une des technologies à la croissance la plus rapide qui utilise des algorithmes d'apprentissage automatique pour former et tester des modèles à l'aide d'énormes données. Les données peuvent être stockées dans différents formats mais pour créer des modèles linguistiques étendus à l'aide de LangChain, le type le plus utilisé est JSON. Les données de formation et de test doivent être claires et complètes, sans aucune ambiguïté, afin que le modèle puisse fonctionner efficacement.

Ce guide démontrera le processus d'utilisation de l'analyseur pydantic JSON dans LangChain.

Comment utiliser l'analyseur Pydantic (JSON) dans LangChain ?

Les données JSON contiennent le format textuel des données qui peuvent être collectées via le web scraping et de nombreuses autres sources telles que les journaux, etc. Pour valider l'exactitude des données, LangChain utilise la bibliothèque pydantic de Python pour simplifier le processus. Pour utiliser l'analyseur pydantic JSON dans LangChain, parcourez simplement ce guide :

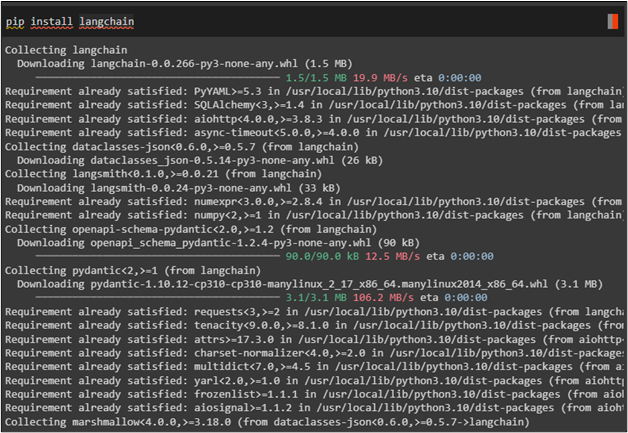

Étape 1 : Installer les modules

Pour démarrer le processus, installez simplement le module LangChain pour utiliser ses bibliothèques pour utiliser l'analyseur dans LangChain :

pépin installer chaîne de langue

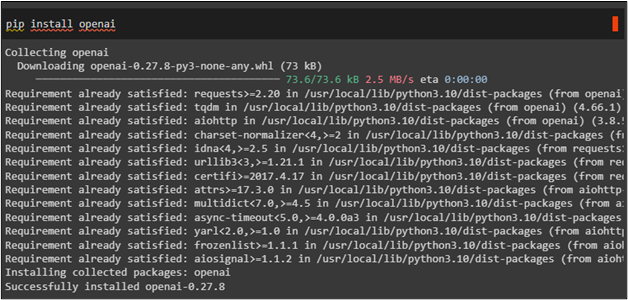

Maintenant, utilisez le ' installation pip » pour obtenir le framework OpenAI et utiliser ses ressources :

pépin installer ouvert

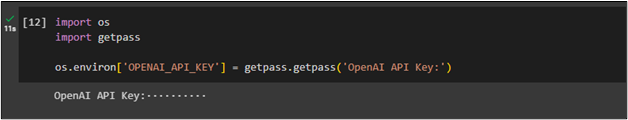

Après avoir installé les modules, connectez-vous simplement à l’environnement OpenAI en fournissant sa clé API à l’aide du « toi ' et ' obtenir un laissez-passer « bibliothèques :

importez-nousimporter getpass

os.environ [ 'OPENAI_API_KEY' ] = getpass.getpass ( « Clé API OpenAI : » )

Étape 2 : Importer des bibliothèques

Utilisez le module LangChain pour importer les bibliothèques nécessaires pouvant être utilisées pour créer un modèle pour l'invite. Le modèle d'invite décrit la méthode permettant de poser des questions en langage naturel afin que le modèle puisse comprendre efficacement l'invite. Importez également des bibliothèques comme OpenAI et ChatOpenAI pour créer des chaînes à l'aide de LLM pour créer un chatbot :

à partir de l'importation langchain.prompts (Modèle d'invite,

Modèle d'invite de chat,

Modèle d'invite de message humain,

)

à partir de langchain.llms, importer OpenAI

depuis langchain.chat_models importer ChatOpenAI

Après cela, importez les bibliothèques pydantiques telles que BaseModel, Field et validateur pour utiliser l'analyseur JSON dans LangChain :

à partir de langchain.output_parsers importer PydanticOutputParserà partir de l'importation pydantic BaseModel, Field, validateur

en tapant la liste d'importation

Étape 3 : Créer un modèle

Après avoir obtenu toutes les bibliothèques permettant d'utiliser l'analyseur pydantic JSON, obtenez simplement le modèle testé préconçu avec la méthode OpenAI() :

nom_modèle = 'texte-davinci-003'température = 0,0

modèle = OpenAI ( nom du modèle =nom_modèle, température =température )

Étape 4 : Configurer le modèle de base de l'acteur

Construisez un autre modèle pour obtenir des réponses liées aux acteurs comme leurs noms et leurs films en demandant la filmographie de l'acteur :

Acteur de classe ( Modèle de base ) :nom : str = Champ ( description = 'Nom de l'acteur principal' )

film_names : Liste [ str ] = Champ ( description = 'Films dans lesquels l'acteur a joué le rôle principal' )

acteur_query = 'Je veux voir la filmographie de n'importe quel acteur'

analyseur = PydanticOutputParser ( pydantic_object =Acteur )

invite = Modèle d'invite (

modèle = 'Répondez à l'invite de l'utilisateur. \n {format_instructions} \n {requête} \n ' ,

variables_d'entrée = [ 'requête' ] ,

variables_partielles = { 'format_instructions' : parser.get_format_instructions ( ) } ,

)

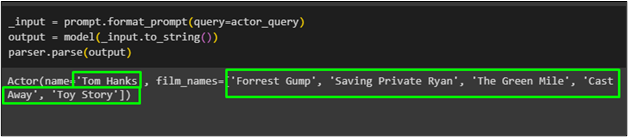

Étape 5 : tester le modèle de base

Obtenez simplement le résultat en utilisant la fonction parse() avec la variable de sortie contenant les résultats générés pour l'invite :

_input = prompt.format_prompt ( requête =acteur_requête )sortie = modèle ( _input.to_string ( ) )

analyseur.parse ( sortir )

L'acteur nommé ' Tom Hanks ' avec la liste de ses films a été récupéré en utilisant la fonction pydantique du modèle :

Il s’agit d’utiliser l’analyseur pydantic JSON dans LangChain.

Conclusion

Pour utiliser l'analyseur pydantic JSON dans LangChain, installez simplement les modules LangChain et OpenAI pour vous connecter à leurs ressources et bibliothèques. Après cela, importez des bibliothèques comme OpenAI et pydantic pour créer un modèle de base et vérifier les données sous forme de JSON. Après avoir construit le modèle de base, exécutez la fonction parse() et elle renvoie les réponses à l'invite. Cet article a démontré le processus d'utilisation de l'analyseur pydantic JSON dans LangChain.