Ce guide illustrera le processus d'utilisation du graphe de connaissances de conversation dans LangChain.

Comment utiliser le graphique de connaissances de conversation dans LangChain ?

Le ConversationKGMémoire La bibliothèque peut être utilisée pour recréer la mémoire qui peut être utilisée pour obtenir le contexte de l'interaction. Pour apprendre le processus d'utilisation du graphe de connaissances de conversation dans LangChain, suivez simplement les étapes répertoriées :

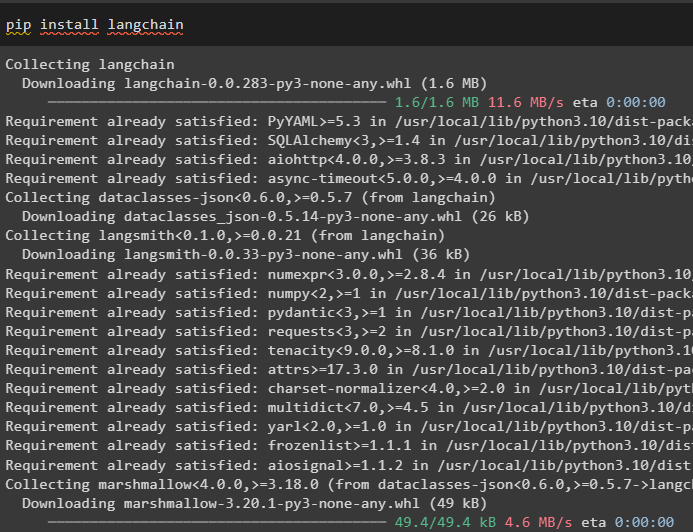

Étape 1 : Installer les modules

Tout d’abord, commencez par utiliser le graphe de connaissances de conversation en installant le module LangChain :

pip installer langchain

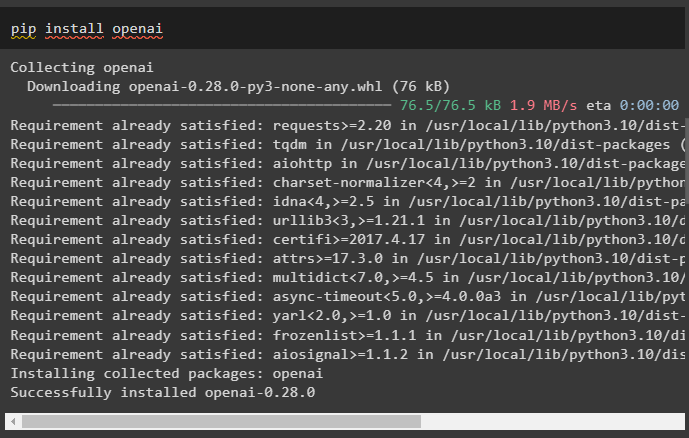

Installez le module OpenAI qui peut être installé à l'aide de la commande pip pour obtenir ses bibliothèques permettant de créer des grands modèles de langage :

pip installer openai

Maintenant, mettre en place l'environnement en utilisant la clé API OpenAI pouvant être générée depuis son compte :

importer toi

importer obtenir un laissez-passer

toi . environ [ 'OPENAI_API_KEY' ] = obtenir un laissez-passer . obtenir un laissez-passer ( « Clé API OpenAI : » )

Étape 2 : Utiliser la mémoire avec les LLM

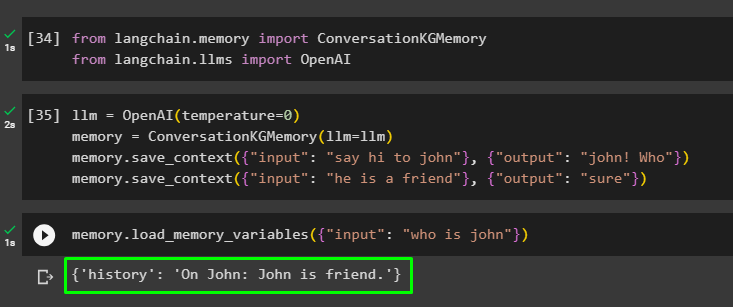

Une fois les modules installés, commencez à utiliser la mémoire avec LLM en important les bibliothèques requises depuis le module LangChain :

depuis chaîne de langage. mémoire importer ConversationKGMémoiredepuis chaîne de langage. llms importer OpenAI

Construisez le LLM à l'aide de la méthode OpenAI() et configurez la mémoire à l'aide du ConversationKGMémoire () méthode. Après cela, enregistrez les modèles d'invite en utilisant plusieurs entrées avec leur réponse respective pour entraîner le modèle sur ces données :

llm = OpenAI ( température = 0 )mémoire = ConversationKGMémoire ( llm = llm )

mémoire. sauvegarder_contexte ( { 'saisir' : 'Dites bonjour à John' } , { 'sortir' : 'John! Qui' } )

mémoire. sauvegarder_contexte ( { 'saisir' : 'c'est un ami' } , { 'sortir' : 'bien sûr' } )

Testez la mémoire en chargeant le variables_mémoire () utilisant la requête liée aux données ci-dessus :

mémoire. load_memory_variables ( { 'saisir' : 'qui est John' } )

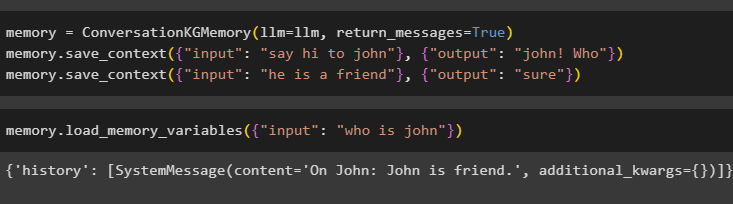

Configurez la mémoire à l'aide de la méthode ConversationKGMemory() avec le return_messages argument pour obtenir également l’historique de l’entrée :

mémoire = ConversationKGMémoire ( llm = llm , return_messages = Vrai )mémoire. sauvegarder_contexte ( { 'saisir' : 'Dites bonjour à John' } , { 'sortir' : 'John! Qui' } )

mémoire. sauvegarder_contexte ( { 'saisir' : 'c'est un ami' } , { 'sortir' : 'bien sûr' } )

Testez simplement la mémoire en fournissant à l'argument d'entrée sa valeur sous la forme d'une requête :

mémoire. load_memory_variables ( { 'saisir' : 'qui est John' } )

Maintenant, testez la mémoire en posant la question qui n'est pas mentionnée dans les données d'entraînement, et le modèle n'a aucune idée de la réponse :

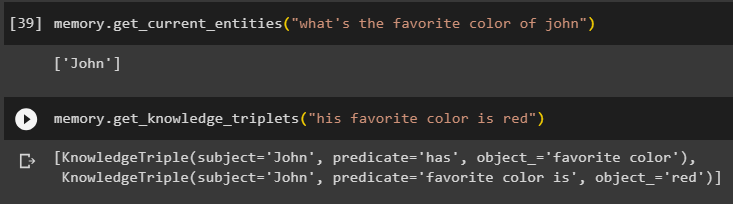

mémoire. get_current_entities ( 'Quelle est la couleur préférée de John' )Utilisez le get_knowledge_triplets () en répondant à la requête posée précédemment :

mémoire. get_knowledge_triplets ( 'sa couleur préférée est le rouge' )

Étape 3 : Utilisation de la mémoire en chaîne

L'étape suivante utilise la mémoire de conversation avec les chaînes pour construire le modèle LLM à l'aide de la méthode OpenAI(). Après cela, configurez le modèle d'invite à l'aide de la structure de conversation et le texte sera affiché tout en obtenant la sortie du modèle :

llm = OpenAI ( température = 0 )depuis chaîne de langage. instructions . rapide importer Modèle d'invite

depuis chaîne de langage. Chaînes importer Chaîne de conversations

modèle = '''C'est le modèle pour l'interaction entre l'homme et la machine

Le système est un modèle d'IA capable de communiquer ou d'extraire des informations sur plusieurs aspects.

S'il ne comprend pas la question ou n'a pas la réponse, il le dit simplement.

Le système extrait les données stockées dans la section 'Spécifique' et n'hallucine pas

Spécifique:

{histoire}

Conversation:

Humain : {entrée}

IA : '''

#Configurez le modèle ou la structure pour fournir des invites et obtenir une réponse du système d'IA

rapide = Modèle d'invite ( variables_d'entrée = [ 'histoire' , 'saisir' ] , modèle = modèle )

conversation_avec_kg = Chaîne de conversations (

llm = llm , verbeux = Vrai , rapide = rapide , mémoire = ConversationKGMémoire ( llm = llm )

)

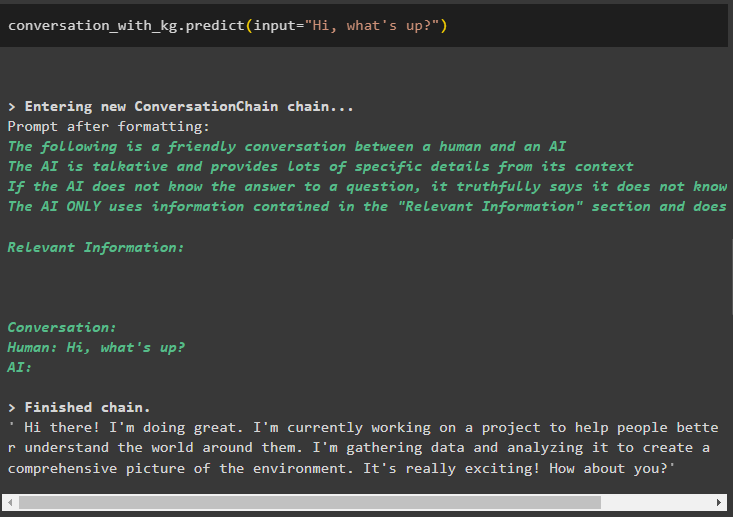

Une fois le modèle créé, appelez simplement le conversation_avec_kg modéliser en utilisant la méthode prédire() avec la requête demandée par l'utilisateur :

conversation_avec_kg. prédire ( saisir = 'Salut, ça va?' )

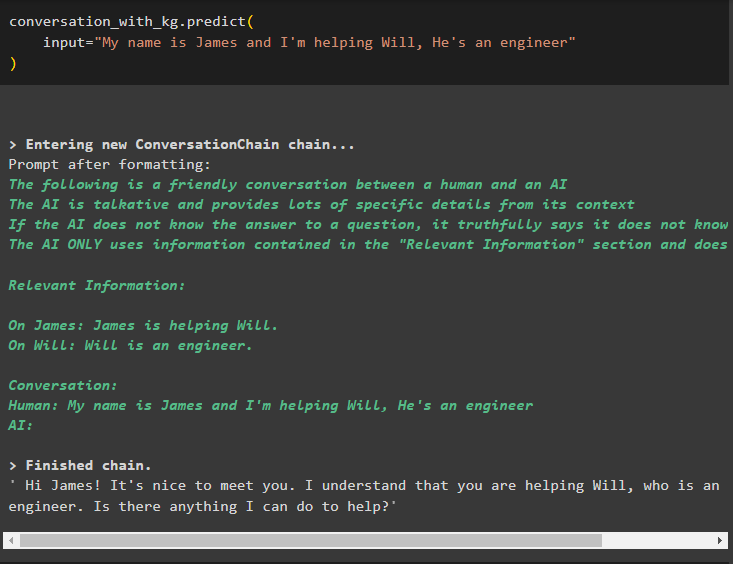

Maintenant, entraînez le modèle à l'aide de la mémoire de conversation en donnant les informations comme argument d'entrée pour la méthode :

conversation_avec_kg. prédire (saisir = 'Je m'appelle James et j'aide Will, il est ingénieur'

)

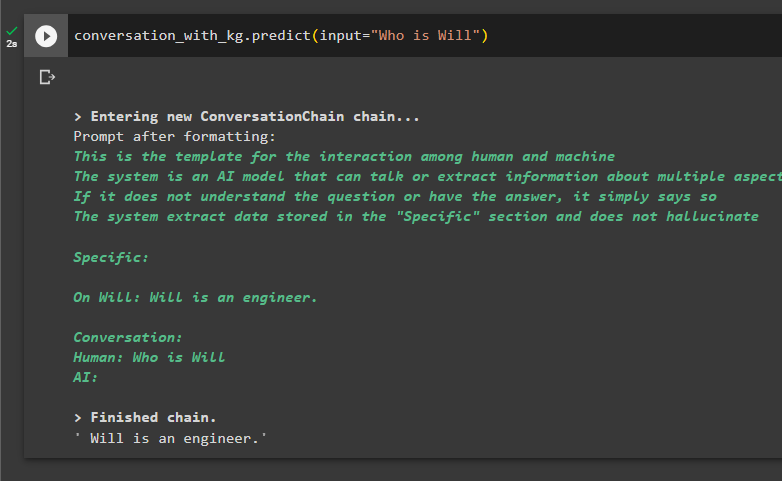

Voici le moment de tester le modèle en demandant aux requêtes d'extraire des informations des données :

conversation_avec_kg. prédire ( saisir = 'Qui est Will' )

Il s’agit d’utiliser le graphique de connaissances de conversation dans LangChain.

Conclusion

Pour utiliser le graphe de connaissances de conversation dans LangChain, installez les modules ou frameworks pour importer des bibliothèques afin d'utiliser la méthode ConversationKGMemory(). Après cela, construisez le modèle en utilisant la mémoire pour construire les chaînes et extraire les informations des données d'entraînement fournies dans la configuration. Ce guide a expliqué le processus d'utilisation du graphe de connaissances de conversation dans LangChain.