Syntaxe:

Comme nous connaissons ChatGPT, nous savons que cette plate-forme appartient à la communauté Open AI et qu'elle fournit des outils, des architectures, des API et plusieurs cadres que nous pouvons utiliser dans le déploiement de nos applications et des modèles de traitement du langage naturel. Open AI propose les API à travers lesquelles nous pouvons utiliser tous les modèles d'IA et de NLP pré-formés de la plate-forme Open AI et les faire fonctionner pour nos applications comme, par exemple, pour donner des prédictions sur des données en temps réel. De même, GPT4All propose également à ses utilisateurs d'intégrer ses modèles d'IA pré-formés à différentes applications.

Le modèle GPT4All est formé sur des données limitées par rapport à ChatGPT. Il a également certaines de ses contraintes de performances par rapport à ChatGPT, mais il permet à l'utilisateur d'utiliser son GPT privé sur son matériel local et ne nécessite aucune connexion réseau. Avec l'aide de cet article, nous apprendrons comment nous pouvons utiliser les modèles GPT4All dans le script Python puisque GPT4All a les liaisons officielles avec Python, ce qui signifie que nous pouvons également utiliser et intégrer les modèles GPT4All via le script Python.

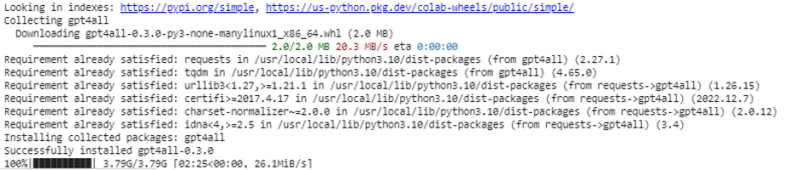

Il suffit d'une commande en ligne pour installer le GPT4All pour l'IDE Python. Ensuite, nous pouvons intégrer autant de modèles d'IA que nos applications. La commande pour installer ce GPT4All en Python est comme indiqué ci-dessous :

$ pip installer gpt4all

Exemple 1:

Pour commencer avec cet exemple, nous devons télécharger et installer Python dans nos systèmes. Les versions recommandées de Python sont la 'version 3.7' ou celles qui sont venues après cette version. Une autre façon de travailler avec Python pour éviter le long processus d'installation de la 'configuration Python' sur nos systèmes consiste à utiliser 'Google Colab', qui est un environnement basé sur le cloud pour Python. Nous pouvons exécuter cet environnement sur n'importe quel navigateur Web et pouvons créer les modèles d'IA et d'apprentissage automatique. Les exemples que nous allons implémenter ici sont exécutés dans Google Colab.

Cet exemple couvre la méthode pour installer le GPT4All en Python et comment utiliser ses modèles pré-formés. Nous commençons par installer d'abord le GPT4All. Pour cela, la commande que nous avons mentionnée précédemment est exécutée. Avec l'exécution de la commande, le GPT4All ainsi que ses packages et frameworks sont téléchargés et installés.

Maintenant, on avance. Depuis GPT4All, nous importons le 'GPT4All'. Cela ajoute tous les modèles pré-formés du GPT4All au projet. Maintenant, nous pouvons utiliser n'importe quel modèle unique et lui faire faire les prédictions pour notre application. Une fois que nous avons importé le package GPT4All, il est maintenant temps d'appeler cette fonction et d'utiliser le modèle GPT4All qui donne la sortie pour la « complétion du chat ».

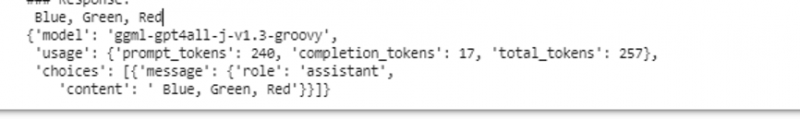

En d'autres termes, si nous demandons quelque chose à ce modèle dans l'entrée, il le renvoie dans la sortie. Le modèle que nous utilisons ici est 'ggml-gpt4all-j-v1.3-groovy'. Ces modèles sont déjà stockés dans le cache GPT4All. Nous pouvons obtenir ces modèles à partir de ce lien ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” pour le téléchargement manuel. Si le modèle est déjà présent dans le cache GPT4All, nous appelons simplement le nom du modèle et le spécifions comme paramètres d'entrée à la fonction 'GPT4All()'. Si nous l'avons téléchargé manuellement avec succès, nous transmettons le chemin d'accès au dossier où se trouve le modèle. Étant donné que ce modèle est destiné à l'achèvement des messages, la syntaxe de ce modèle est donnée comme suit :

$ Chat_completion (messages)Les messages sont une liste de dictionnaires et chaque dictionnaire doit contenir une clé 'rôle' avec une valeur de l'utilisateur, du système ou de l'assistant, et le contenu 'clé' qui a la valeur comme chaîne. Dans cet exemple, nous spécifions le contenu comme 'nom trois couleurs' et la clé de rôle comme 'utilisateur'.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': 'Nommez 3 fleurs'}]

Après cette spécification, nous appelons la fonction « chat_completion() » avec le modèle. Le code correspondant s'affiche dans la sortie suivante :

$ !pip installer gpt4allde gpt4all importer GPT4All

modèle = GPT4All('ggml-gpt4all-j-v1.3-groovy')

messages = [{'role': 'user', 'content': 'Nommez trois couleurs'}]

modèle.chat_completion(messages)

Après l'exécution de cet exemple, le modèle renvoie trois couleurs comme réponse à l'entrée.

Exemple 2 :

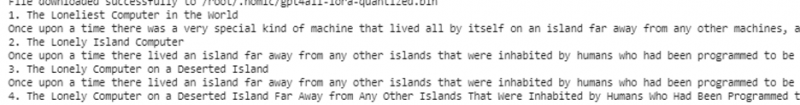

Nous couvrons un autre exemple où nous découvrons une autre méthode pour utiliser le GPT4All en Python. Cela peut être fait en utilisant les liaisons officielles pour Python qui sont fournies par 'Nomic' qui est une communauté d'IA open source, et qui exécute le GPT4All. À l'aide de la commande suivante, nous intégrons 'nomic' dans notre console Python :

$ pip installer nomicUne fois celui-ci installé, nous importons le GPT4All depuis « nomic.gpt4all ». Après avoir importé GPT4All, nous initialisons le GPT4All avec la fonction 'open()'. Ensuite, nous appelons la fonction 'prompt ()' et transmettons une invite à cette fonction. Ensuite, une réponse rapide est générée en fonction de l'invite que nous avons donnée en entrée du modèle d'invite.

!pip installer nomicdepuis nomic.gpt4all importer GPT4All

# Initialiser le modèle GPT4All

initier = GPT4All()

initier.open()

# Génération d'une réponse basée sur l'invite

model_response = initiate.prompt('écrire une courte histoire sur un ordinateur)

# affichage de la réponse générée

imprimer(model_response)

La sortie affiche la réponse rapide du modèle que nous avons généré à l'aide du modèle GPT4All pré-formé en Python. Si nous voulons en savoir plus sur les modèles et comment nous pouvons utiliser ces modèles pour générer les réponses, ou en termes simples, si nous voulons acquérir des connaissances sur la syntaxe pour générer les réponses à partir de ces modèles, nous pouvons demander une aide supplémentaire du GPT4Tous les détails de la documentation technique.

Conclusion

GPT4All s'efforce toujours d'obtenir la précision des performances. Il est géré par la plate-forme nomic AI qui vise à fournir des chatbots artificiellement intelligents à ses utilisateurs sur les processeurs grand public puisque GPT4All fonctionne sans connexion réseau ni GPU. Cet article nous éclaire pour utiliser efficacement le PyGPT4All dans un environnement Python et pour créer une interaction entre nos applications et les modèles d'IA GPT4All pré-formés. Nous avons couvert deux méthodes différentes pour installer GPT4All en Python dans ce guide.