Les limites de ressources sont une partie importante de l'orchestration des conteneurs Kubernetes, car elles garantissent que les conteneurs ne consomment pas trop de ressources ou ne répondent pas en raison de l'épuisement des ressources. Cet article fournit un guide sur la façon de définir les limites des ressources du conteneur Kubernetes pour maximiser leurs avantages et tirer le meilleur parti de vos applications. Découvrez comment configurer et gérer vos ressources de conteneurs rapidement et facilement en quelques étapes simples afin d'être sûr que tous vos services fonctionnent correctement.

Définir les limites des ressources de conteneur dans Kubernetes

Les limites de ressources de conteneur sont un élément essentiel de Kubernetes, permettant aux utilisateurs de gérer le nombre de ressources qu'un conteneur peut consommer. Pour éviter les surcharges et garantir les performances d'une application, ceci est particulièrement crucial dans les contextes de production. Voici quelques conseils de pro pour définir les limites des ressources du conteneur :

Commencez par déterminer les ressources dont vos conteneurs ont besoin. Analysez l'utilisation de votre système et déterminez les conteneurs dont les limites de mémoire et de CPU doivent être ajustées. Il est également important de prendre en compte les nœuds sous-jacents lors de la définition des limites de ressources - si vous définissez une limite trop élevée ou trop basse, le nœud peut ne pas être en mesure d'exécuter les autres applications sans planter. Ensuite, décidez du type de limite que vous souhaitez utiliser - extensible ou non extensible. Voyons maintenant les étapes nécessaires que vous pouvez suivre pour définir les limites des ressources du conteneur Kubernetes. Avant de vous diriger vers les étapes, il y a quelques prérequis nécessaires :

Conditions préalables

Avant de passer aux étapes, assurons-nous que notre système répond à tous les besoins des prérequis. Assurez-vous d'avoir Ubuntu 20.04 ou toute autre version la plus récente pour avoir un environnement Linux/Unix pour fonctionner, un cluster Kubernetes, Kubectl CLI pour utiliser les commandes kubectl, la communication du cluster, gérer l'environnement de développement et minikube ou tout autre terrain de jeu Kubernetes pour créer le groupes. Installez ces outils si vous ne les avez pas encore installés avant de passer à la section suivante. Passons maintenant au guide étape par étape sur la façon de définir les limites des ressources du conteneur Kubernetes.

Comment définir les limites de ressources Kubernetes

La définition des limites de ressources du conteneur Kubernetes est une partie importante de la gestion et de la maintenance de vos clusters Kubernetes. La mise en place d'une limite de ressources appropriée garantit que chaque conteneur fonctionne de manière optimale, sans compromettre les performances des autres conteneurs ou de l'ensemble du cluster. Cela peut être fait en définissant les demandes de ressources et les limites pour le processeur, la mémoire, le stockage éphémère, etc. Voici comment définir correctement les limites de ressources du conteneur Kubernetes.

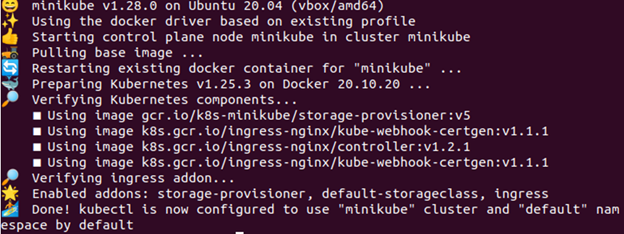

Étape 1 : Démarrez le Minikube

Le cluster Minikube doit être dans un état actif pour que vous puissiez y exécuter vos applications ou vos commandes. Pour vous assurer qu'il est opérationnel correctement, utilisez la commande suivante :

> commencer minikube

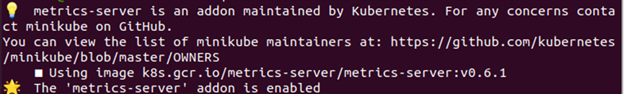

Étape 2 : Activer le serveur de mesures

Dans cette étape, nous partageons la commande qui vous permet d'activer le serveur de métriques. La commande est donnée dans ce qui suit :

> modules minikube permettre serveur de métriques

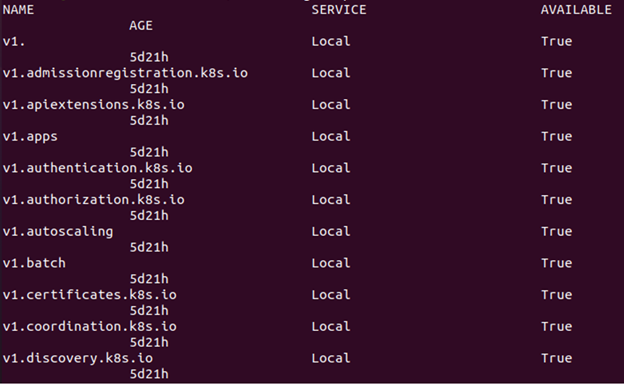

Étape 3 : Vérifier si le serveur de métriques est actif ou non

Tapez la commande suivante pour vérifier si le serveur de métriques est actif ou non :

> kubectl obtenir des services d'api

Comme on le voit dans l'image précédente, il contient une référence à metrics.k8s.io au cas où l'API des métriques de ressources est accessible.

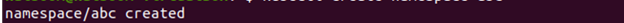

Étape 4 : Créer un espace de noms

Pour conserver les ressources, vous créez un espace de noms pour cet exercice qui est distinct du reste de votre cluster. Nous montrons maintenant comment créer un espace de noms. La commande qui s'exécute est donnée comme suit :

> kubectl créer un espace de noms ABC

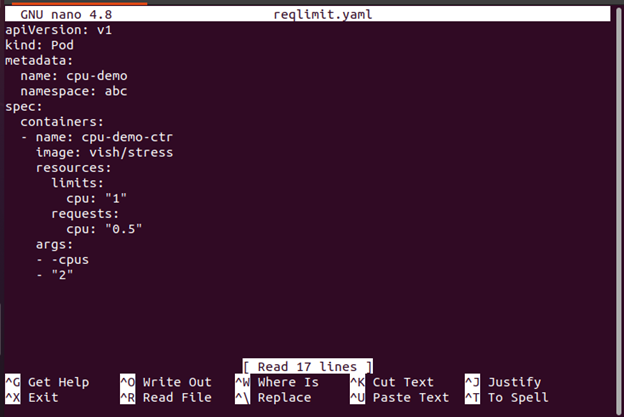

Étape 5 : créer un fichier de configuration

Le fichier de configuration YAML que nous utilisons pour construire un pod dans le conteneur est créé à cette étape. Voici la commande qui est utilisée pour accomplir ceci :

> nano reqlimit.yamlIci, vous devez inclure une demande de CPU avec une limite de CPU. Incluez les resources:limits pour définir une limite de CPU. Dans ce cas, un Pod avec un seul conteneur est créé. Le conteneur a une limite de requête de 0,5 CPU et un maximum de 1 CPU. Le fichier de configuration du Pod est disponible ici. Comme vous pouvez le voir, la section args du fichier de configuration contient les arguments que le conteneur utilise lorsqu'il démarre. Le conteneur est chargé d'essayer d'utiliser les 2 CPU via le paramètre -cpus '2'.

Lors de la création de ressources dans Kubernetes telles que des déploiements et des pods, il est important de spécifier le nombre minimum de ressources requises (demande) et le nombre maximum de ressources autorisées (limite) pour chaque pod ou déploiement. Cela empêche un pod de consommer trop de ressources, ce qui pourrait entraîner une diminution des performances des autres pods actifs ou même un plantage en raison d'un manque de ressources disponibles sur le cluster.

Étape 6 : créer un module

Maintenant, nous vous montrons comment créer le pod avec la commande suivante :

> kubectl créer -F reqlimit.yaml

À partir de la sortie précédente, vous pouvez remarquer que le pod nommé 'cpu-demo' est créé.

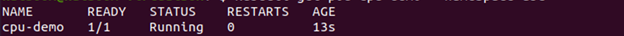

Étape 7 : Vérifier le pod

Dans cette étape, nous vérifions si le pod créé est actif ou non avec la commande suivante :

> kubectl obtenir la démo du processeur du pod --espace de noms = abc

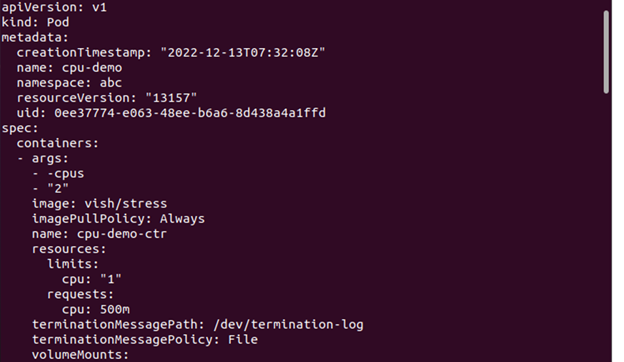

Étape 8 : Afficher les détails du module

Maintenant, si vous souhaitez afficher les informations détaillées sur le Pod, voici la commande à exécuter :

> kubectl obtenir la démo du processeur du pod --sortir = yaml --espace de noms = abc

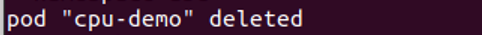

Étape 9 : Supprimer le pod

Ici, nous allons montrer comment supprimer le pod pour nettoyer les ressources. La commande utilisée à cet effet est la suivante :

> kubectl supprimer pod cpu-demo --espace de noms = abc

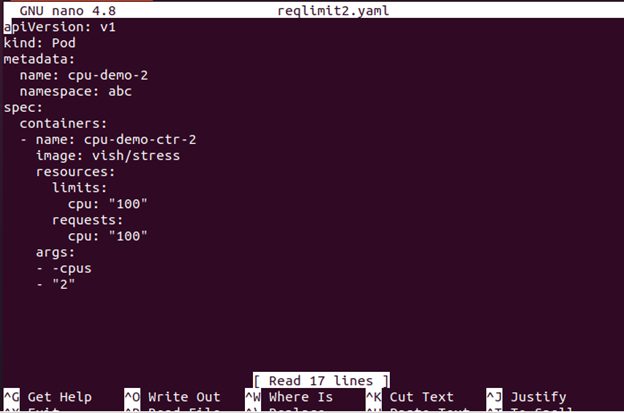

Étape 10 : créer un fichier de configuration

Dans cette étape, nous créons un fichier de configuration. Ce fichier spécifie une requête CPU assez importante pour vos nœuds.

> nano reqlimit2Le fichier de configuration avec un seul conteneur peut être trouvé ici. Le conteneur demande 100 CPU, ce qui est plus que n'importe quel nœud que votre cluster peut raisonnablement fournir.

Étape 11 : Créer un le Pod

Dans cette étape, nous créons le pod avec la commande suivante :

> kubectl créer -F reqlimit2.yaml

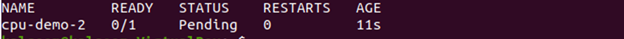

Étape 12 : Afficher l'état du pod

Maintenant, vous pouvez voir le st un tus du pod avec la commande jointe ici :

La sortie indique que l'état du pod est En attente.

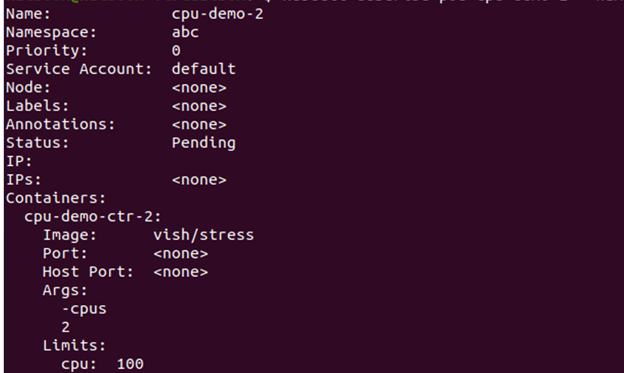

Étape 13 : Voir les informations sur le pod

Maintenant, nous visualisons les informations détaillées sur le pod, y compris les événements avec la commande donnée ici :

Allez dans la section événement et voyez si le conteneur est planifié ou non.

S'il ne peut pas être planifié et que la raison est l'insuffisance des ressources CPU, vous pouvez supprimer le nœud. La procédure de suppression d'un nœud est expliquée à l'étape suivante.

Étape 14 : Supprimer le nœud

Vous pouvez supprimer le nœud avec la commande suivante :

> kubectl delete pod cpu-demo- 2 --espace de noms = abc

Quel est l'impact des limites de ressources de conteneur sur les performances ?

Avec la popularité croissante de la technologie de conteneur Kubernetes, il est important de comprendre comment les limites de ressources peuvent avoir un impact sur les performances. La définition des limites de ressources dans un conteneur Kubernetes peut vous aider à vous assurer que vos applications s'exécutent à leur niveau optimal et qu'elles ne consomment pas trop de ressources du serveur hôte. En limitant les ressources, vous pouvez éviter les processus redondants inutiles, aider à prévenir les pannes du système dues à l'utilisation et optimiser les performances de vos conteneurs.

Pour définir ces limites de ressources dans un conteneur Kubernetes, vous devez utiliser un outil appelé cgroups (groupes de contrôle). Les groupes de contrôle permettent aux administrateurs de limiter les ressources telles que les cycles CPU ou l'utilisation de la mémoire pour les conteneurs individuels. Vous pouvez également définir les autres paramètres tels que la taille maximale des fichiers ou l'utilisation de la bande passante réseau par conteneur.

Conclusion

La définition des limites de ressources du conteneur Kubernetes est un élément crucial de la gestion de votre environnement de cloud computing. Avec la configuration appropriée, vous pouvez vous assurer que chaque conteneur a accès aux ressources dont il a besoin, mais pas au point d'affecter d'autres conteneurs ou systèmes. Cela permet une utilisation plus efficace et plus rentable des ressources informatiques. De plus, en limitant la quantité de mémoire ou de CPU qu'un conteneur peut consommer, vous pouvez empêcher les pannes de se produire en raison de processus incontrôlables ou de pics d'utilisation inattendus.