Nettoyer les données avec Python et Pandas

Les données sont aujourd’hui comme les éléments constitutifs de la prise de décision. Mais imaginez avoir un groupe de blocs de formes et de tailles différentes de cette collection ; il est difficile de construire quelque chose de significatif. C’est là que le nettoyage des données entre en jeu.

Ce guide explique comment nettoyer les données à l'aide du framework Python, Pandas, pour une meilleure prise de décision. Le nettoyage des données est également essentiel, étant donné que nous travaillons avec une liste d'enregistrements de ventes pour un magasin. Nous pourrions remarquer des numéros manquants, des dates étranges et des éléments répétés sans raison dans la liste. Si nous effectuons des calculs ou des enregistrements sur la base de ces informations, ces problèmes peuvent perturber nos calculs et nos prévisions. Le nettoyage des données aide à résoudre ces problèmes, en garantissant que nos données sont exactes et prêtes à être utilisées.

Le nettoyage des données comprend la gestion des données manquantes et ce qu'il faut faire lorsque certaines données sont manquantes, la suppression des doublons, l'élimination des éléments copiés, la correction des types de données, la garantie que tout est dans le bon format et le traitement des valeurs aberrantes ou la gestion des chiffres. qui ne rentrent pas dans le cadre. Ces erreurs donnent aux données une apparence identique et standardisent leur apparence.

Pour commencer, assurez-vous d’abord que Python et Pandas sont installés. Nous pouvons le faire en tapant les commandes dans le terminal ou l’invite de commande de notre ordinateur. Pour implémenter les codes mentionnés dans ce guide, nous pouvons utiliser l'IDE Python Pycharm installé sur notre système ou la plateforme Python en ligne qui est « Google Colab » et installer les commandes « pip » pour installer les bibliothèques importantes.

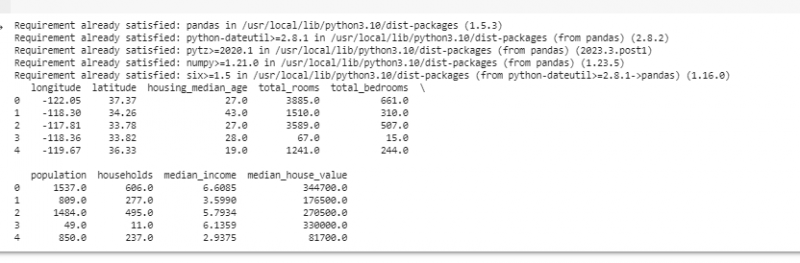

Maintenant, importons Pandas et chargeons nos exemples de données. Pour cet exemple, nous utilisons Google Colab pour exécuter les codes. Nous importons donc d’abord Pandas en entrant la commande suivante :

! pip installer les pandas

importer pandas comme pd

importer numpy comme par exemple.

Ensuite, nous chargeons l'ensemble de données que nous souhaitons afficher à l'aide de la méthode pd.read() qui prend le chemin du fichier comme paramètre d'entrée.

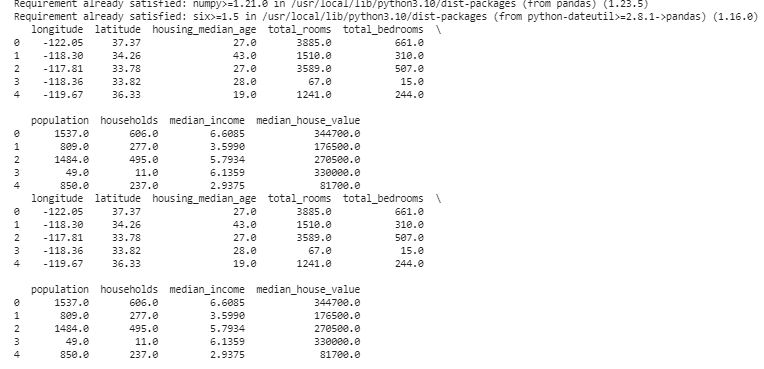

# Charger l'ensemble de donnéesdonnées = p.d. lire_csv ( '/content/sample_data/california_housing_test.csv' )

# Afficher les premières lignes

imprimer ( données. tête ( ) )

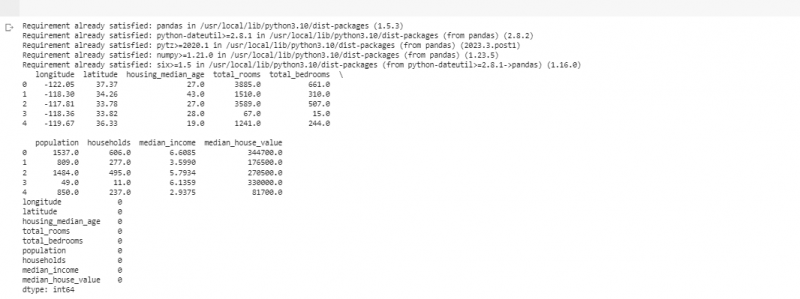

Dans l'exemple suivant, nous utilisons les données sur les ventes dans un petit magasin. Pour gérer les données manquantes, l'information manque parfois dans nos données. Nous appelons ces parties manquantes « NaN » (ce qui signifie « pas un nombre »). Pour trouver ces valeurs manquantes dans le script Python, nous chargeons d'abord l'ensemble de données comme nous l'avons fait dans l'exemple précédent. Ensuite, nous trouvons toutes les valeurs manquantes dans l'ensemble de données à l'aide de la fonction « missing_values = data.isnull().sum() ». Cette fonction trouve toutes les valeurs manquantes dans l'ensemble de données. Ensuite, nous les affichons à l’aide de la fonction print().

! pip installer les pandasimporter pandas comme pd

importer numpy comme par exemple.

# Charger l'ensemble de données

données = p.d. lire_csv ( '/content/sample_data/california_housing_test.csv' )

# Afficher les premières lignes

imprimer ( données. tête ( ) )

# Vérifier les valeurs manquantes

valeurs_manquantes = données. est nul ( ) . somme ( )

# Afficher le nombre de valeurs manquantes par colonne

imprimer ( valeurs_manquantes )

Après avoir trouvé des données manquantes dans une ligne qui exécute le code mentionné précédemment, nous pouvons supprimer ces lignes car elles ne contiennent pas beaucoup de données utiles. Nous pouvons même deviner ces valeurs manquantes et combler les vides avec des suppositions éclairées en estimant les données temporelles en fonction de points proches.

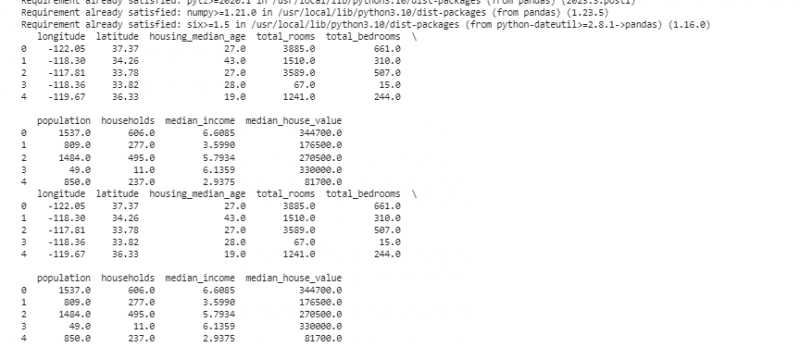

Maintenant, nous supprimons les doublons qui sont des copies de la même chose car ils peuvent brouiller notre analyse. Pour trouver les valeurs en double dans l'ensemble de données, nous utilisons la fonction « duplicate_rows = data[data.duplicate()] ». Pour supprimer ces valeurs en double, nous appelons la fonction data.drop_duplicates(). Nous pouvons les trouver et les supprimer en utilisant le code suivant :

! pip installer les pandasimporter pandas comme pd

importer numpy comme par exemple.

# Charger l'ensemble de données

données = p.d. lire_csv ( '/content/sample_data/california_housing_test.csv' )

# Afficher les premières lignes

imprimer ( données. tête ( ) )

# Vérifier les lignes en double

lignes_dupliquées = données [ données. dupliqué ( ) ]

# Supprimer les doublons

données = données. drop_duplicates ( )

# Afficher les premières lignes après avoir supprimé les doublons

imprimer ( données. tête ( ) )

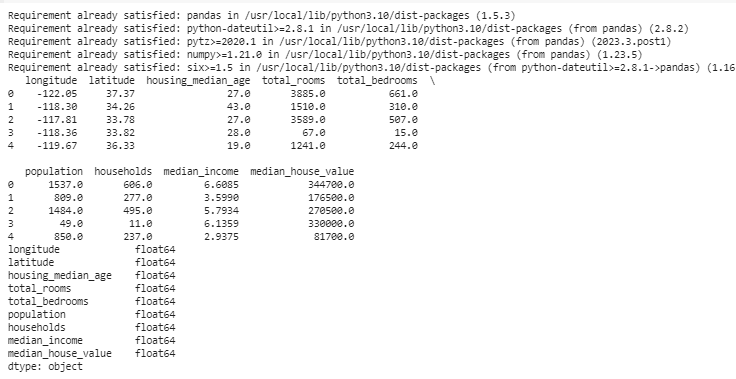

Les types de données décident quelles données peuvent être stockées pour corriger les types de données. Il est essentiel d’avoir le bon type pour chaque type de données. Par exemple, les dates doivent avoir le type de données date heure et les nombres doivent être dans un type de données comme int, float, etc. Pour vérifier les types de données de nos données, nous utilisons la fonction « data.dtypes ». Cette fonction peut être utilisée de la manière suivante :

! pip installer les pandasimporter pandas comme pd

importer numpy comme par exemple.

# Charger l'ensemble de données

données = p.d. lire_csv ( '/content/sample_data/california_housing_test.csv' )

# Afficher les premières lignes

imprimer ( données. tête ( ) )

# Vérifiez les types de données de chaque colonne

Types de données = données. types

# Afficher les types de données

imprimer ( Types de données )

Si nous rencontrons des problèmes, nous pouvons modifier le type de données à l'aide de Pandas. Par exemple, nous pouvons transformer les dates en un format de date. L'attribut « dtypes » d'un DataFrame fournit des informations sur les types de données de chaque colonne. Si nous constatons que le type de données ne correspond pas, nous pouvons utiliser la fonction astype() de Pandas pour convertir les colonnes aux types souhaités.

Après les types de données, on rencontre parfois des valeurs aberrantes qui sont des valeurs très différentes des autres. Ils peuvent gâcher nos calculs. Pour traiter les valeurs aberrantes, nous définissons une fonction qui utilise la fonction z-score « np.abs(stats.zscore(data)) » qui compare les valeurs qui existent dans nos données avec la valeur seuil. Toute valeur autre que la plage de ce seuil est considérée comme une valeur aberrante . Voyons comment trouver et gérer les valeurs aberrantes :

! pip installer les pandasimporter pandas comme pd

importer numpy comme par exemple.

# Charger l'ensemble de données

données = p.d. lire_csv ( '/content/sample_data/california_housing_test.csv' )

# Afficher les premières lignes

imprimer ( données. tête ( ) )

depuis scipy importer Statistiques

déf détecter_outliers ( données ) :

z_scores = par exemple. abdos ( Statistiques. zscore ( données ) )

retour par exemple. où ( z_scores > 3 )

# Détecter et gérer les valeurs aberrantes dans la colonne 'Ventes'

valeurs aberrantes = détecter_outliers ( données [ 'longitude' ] )

données [ 'longitude' ] . lieu [ valeurs aberrantes ] = données [ 'longitude' ] . médian ( )

# Détecter et gérer les valeurs aberrantes dans la colonne « Unités vendues »

valeurs aberrantes = détecter_outliers ( données [ 'latitude' ] )

données [ 'latitude' ] . lieu [ valeurs aberrantes ] = données [ 'latitude' ] . médian ( )

# Afficher les premières lignes après avoir traité les valeurs aberrantes

imprimer ( données. tête ( ) )

Nous utilisons une méthode simple pour rechercher et corriger les valeurs aberrantes dans le code précédent. Cela implique de remplacer les valeurs extrêmes par la valeur moyenne des données. Ce code utilise la méthode Z-score pour détecter les valeurs aberrantes dans les colonnes « longitude » et « latitude » de notre ensemble de données. Les valeurs aberrantes sont remplacées par les valeurs médianes de leurs colonnes respectives.

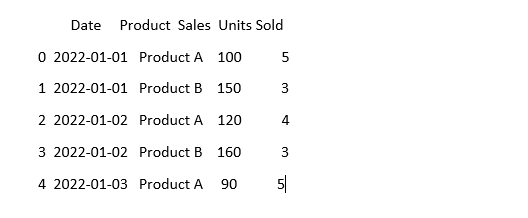

Pour que les données se ressemblent, les données peuvent parfois paraître différentes même si elles signifient la même chose. Par exemple, les dates peuvent être écrites dans différents formats. La normalisation implique de garantir un format et une représentation cohérents des données. Cela peut inclure le formatage des dates, la conversion du texte en minuscules ou la normalisation des valeurs numériques. Standardisons la colonne « Date » dans notre ensemble de données et assurons-nous que nos données se ressemblent :

importer pandas comme pdimporter numpy comme par exemple. # Importer numpy

# Charger les données

données = p.d. lire_csv ( 'sales_data.csv' )

# Rendre la colonne 'Date' cohérente

données [ 'Date' ] = p.d. to_datetime ( données [ 'Date' ] )

# Voyez à quoi ça ressemble maintenant

imprimer ( données. tête ( ) )

Dans cet exemple, nous standardisons le format de date de notre ensemble de données au format datetime de Python à l'aide de la fonction « pd.to_datetime(data['Date']) ». En convertissant la colonne « Date » dans le même format, nous facilitons le travail avec ces données. La sortie affiche les premières lignes de l’ensemble de données avec la colonne « Date » standardisée.

Conclusion

Au cours de notre parcours de nettoyage des données à l'aide de Python et Pandas, nous avons appris comment améliorer nos données à des fins d'analyse. Nous avons commencé par comprendre pourquoi le nettoyage des données est si important. Cela nous aide à prendre de meilleures décisions. Nous avons exploré comment gérer les données manquantes, supprimer les doublons, corriger les types de données, gérer les valeurs aberrantes et donner à nos données la même apparence. Grâce à ces compétences, nous sommes mieux préparés à transformer des données désordonnées en quelque chose auquel nous pouvons faire confiance et utiliser pour découvrir une information importante. Le nettoyage des données est un processus continu, comme garder notre chambre en ordre, et il rend notre parcours d'analyse des données plus réussi.