Aperçu rapide

Cet article démontrera ce qui suit :

- Comment accéder aux étapes intermédiaires d'un agent dans LangChain

- Installation de frameworks

- Configuration de l'environnement OpenAI

- Importation de bibliothèques

- Bâtiment LLM et Agent

- Utilisation de l'agent

- Méthode 1 : type de retour par défaut pour accéder aux étapes intermédiaires

- Méthode 2 : Utiliser des « dumps » pour accéder aux étapes intermédiaires

- Conclusion

Comment accéder aux étapes intermédiaires d'un agent dans LangChain ?

Pour créer l'agent dans LangChain, l'utilisateur doit configurer ses outils et la structure du modèle pour obtenir le nombre d'étapes impliquées dans le modèle. L'agent est chargé d'automatiser les étapes intermédiaires comme les pensées, les actions, les observations, etc. Pour savoir comment accéder aux étapes intermédiaires d'un agent dans LangChain, suivez simplement les étapes répertoriées :

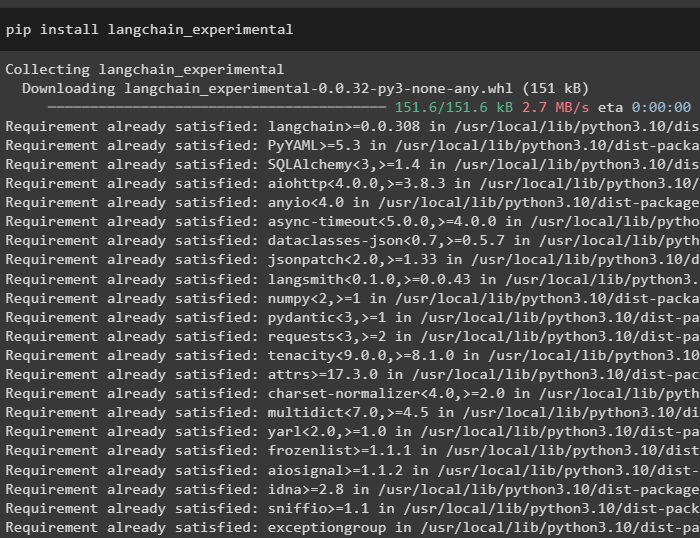

Étape 1 : Installation des frameworks

Tout d’abord, installez simplement les dépendances du LangChain en exécutant le code suivant dans le Python Notebook :

pip installer langchain_experimental

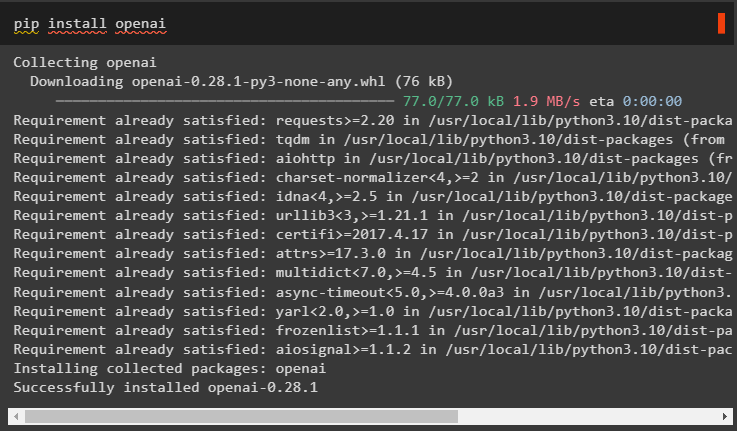

Installez le module OpenAI pour obtenir ses dépendances à l'aide du pépin commande et utilisez-les pour créer le modèle de langage :

pip installer openai

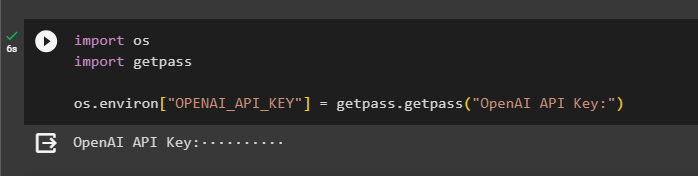

Étape 2 : Configuration de l'environnement OpenAI

Une fois les modules installés, configurez le Environnement OpenAI en utilisant la clé API générée depuis son compte :

importer toi

importer obtenir un laissez-passer

toi. environ [ 'OPENAI_API_KEY' ] = passe-passe. obtenir un laissez-passer ( « Clé API OpenAI : » )

Étape 3 : Importer des bibliothèques

Maintenant que les dépendances sont installées, utilisez-les pour importer des bibliothèques depuis LangChain :

de Langchain. agents importer charger_toolsde Langchain. agents importer initialiser_agent

de Langchain. agents importer Type d'agent

de Langchain. llms importer OpenAI

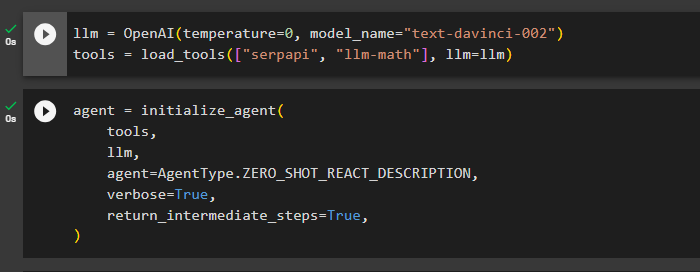

Étape 4 : Créer un LLM et un agent

Une fois les bibliothèques importées, il est temps de les utiliser pour créer le modèle de langage et les outils de l'agent. Définissez la variable llm et affectez-la avec la méthode OpenAI() contenant les arguments température et nom_modèle. Le ' outils La variable ' contient la méthode load_tools() avec les outils SerpAPi et llm-math et le modèle de langage dans son argument :

llm = OpenAI ( température = 0 , nom du modèle = 'texte-davinci-002' )outils = charger_tools ( [ 'serpapi' , 'llm-math' ] , llm = llm )

Une fois le modèle de langage et les outils configurés, concevez simplement l'agent pour qu'il effectue les étapes intermédiaires à l'aide des outils du modèle de langage :

agent = initialiser_agent (outils ,

llm ,

agent = Type d'agent. ZERO_SHOT_REACT_DESCRIPTION ,

verbeux = Vrai ,

return_intermediate_steps = Vrai ,

)

Étape 5 : Utilisation de l'agent

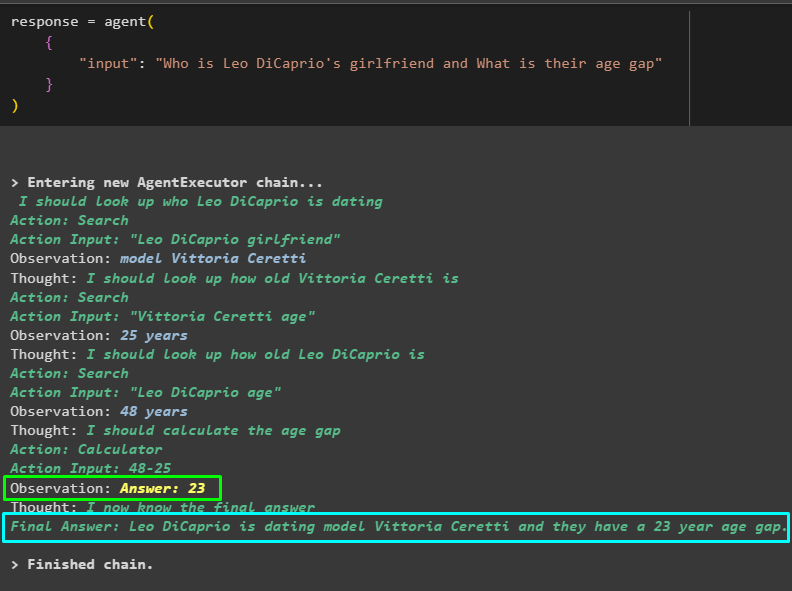

Maintenant, mettez l'agent à l'épreuve en posant une question dans l'entrée de la méthode agent() et en l'exécutant :

réponse = agent ({

'saisir' : 'Qui est la petite amie de Leo DiCaprio et quel est leur écart d'âge'

}

)

Le mannequin a travaillé efficacement pour obtenir le nom de la petite amie de Leo DiCaprio, son âge, celui de Leo DiCaprio et la différence entre eux. La capture d'écran suivante affiche plusieurs questions et réponses recherchées par l'agent pour obtenir la réponse finale :

La capture d'écran ci-dessus n'affiche pas le fonctionnement de l'agent ni comment il parvient à cette étape pour trouver toutes les réponses. Passons à la section suivante pour connaître les étapes :

Méthode 1 : type de retour par défaut pour accéder aux étapes intermédiaires

La première méthode pour accéder à l'étape intermédiaire consiste à utiliser le type de retour par défaut proposé par LangChain en utilisant le code suivant :

imprimer ( réponse [ 'étapes_intermédiaires' ] )Le GIF suivant affiche les étapes intermédiaires sur une seule ligne, ce qui n'est pas très bon en termes de lisibilité :

Méthode 2 : Utiliser des « dumps » pour accéder aux étapes intermédiaires

La méthode suivante explique une autre façon d'obtenir les étapes intermédiaires en utilisant la bibliothèque de dump du framework LangChain. Utilisez la méthode dumps() avec l'argument joli pour rendre la sortie plus structurée et plus facile à lire :

de Langchain. charger . décharge importer déchargesimprimer ( décharges ( réponse [ 'étapes_intermédiaires' ] , joli = Vrai ) )

Nous disposons désormais du résultat sous une forme plus structurée et facilement lisible par l’utilisateur. Il est également divisé en plusieurs sections pour plus de sens et chaque section contient les étapes pour trouver des réponses aux questions :

Il s’agit d’accéder aux étapes intermédiaires d’un agent dans LangChain.

Conclusion

Pour accéder aux étapes intermédiaires d'un agent dans LangChain, installez les modules pour importer des bibliothèques pour construire des modèles de langage. Après cela, configurez les outils pour initialiser l'agent à l'aide des outils, du llm et du type d'agent capables de répondre aux questions. Une fois l'agent configuré, testez-le pour obtenir les réponses puis utilisez la bibliothèque de types par défaut ou de dumps pour accéder aux étapes intermédiaires. Ce guide a développé le processus d'accès aux étapes intermédiaires d'un agent dans LangChain.