Cet article illustre la méthode d'utilisation des fonctions et des classes de l'analyseur de sortie via le framework LangChain.

Comment utiliser l'analyseur de sortie via LangChain ?

Les analyseurs de sortie sont les sorties et les classes qui peuvent aider à obtenir la sortie structurée du modèle. Pour apprendre le processus d'utilisation des analyseurs de sortie dans LangChain, suivez simplement les étapes répertoriées :

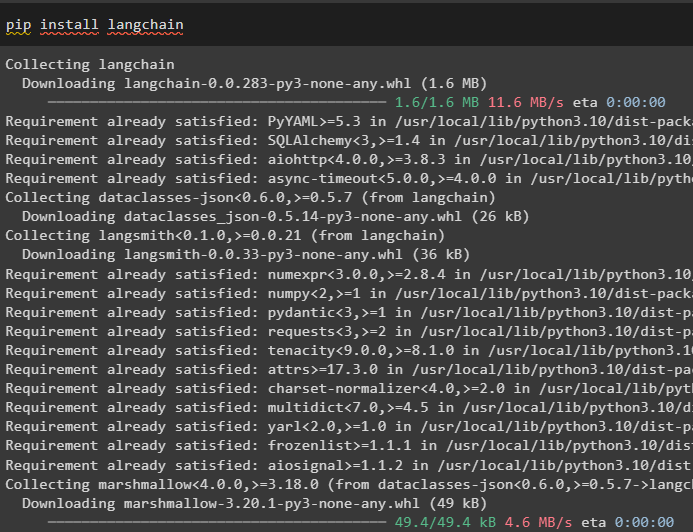

Étape 1 : Installer les modules

Tout d'abord, démarrez le processus d'utilisation des analyseurs de sortie en installant le module LangChain avec ses dépendances pour suivre le processus :

pépin installer chaîne de langue

Après cela, installez le module OpenAI pour utiliser ses bibliothèques comme OpenAI et ChatOpenAI :

pépin installer ouvert

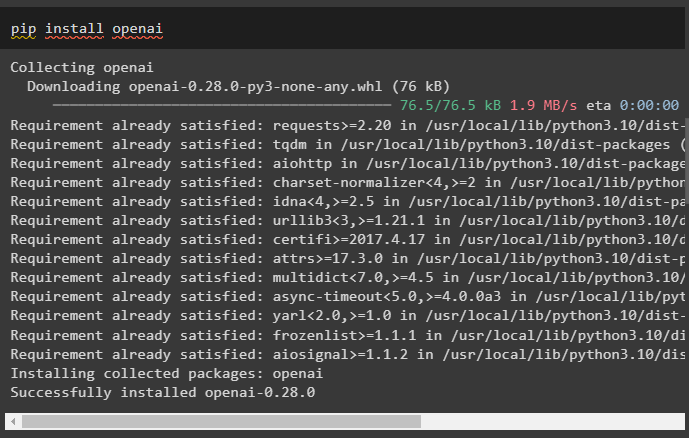

Maintenant, configurez le environnement pour l'OpenAI en utilisant la clé API du compte OpenAI :

importez-nous

importer getpass

os.environ [ 'OPENAI_API_KEY' ] = getpass.getpass ( « Clé API OpenAI : » )

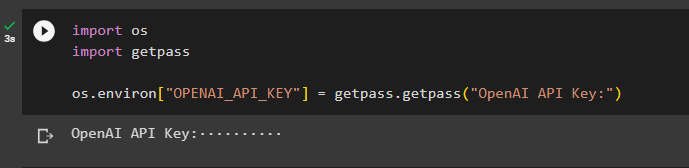

Étape 2 : Importer des bibliothèques

L'étape suivante consiste à importer les bibliothèques depuis LangChain pour utiliser les analyseurs de sortie dans le framework :

à partir de langchain.prompts, importez HumanMessagePromptTemplate

du champ d'importation pydantic

à partir de langchain.prompts, importez ChatPromptTemplate

à partir de langchain.output_parsers importer PydanticOutputParser

à partir de l'importation pydantique BaseModel

du validateur d'importation pydantic

depuis langchain.chat_models importer ChatOpenAI

à partir de langchain.llms, importer OpenAI

en tapant la liste d'importation

Étape 3 : Création d'une structure de données

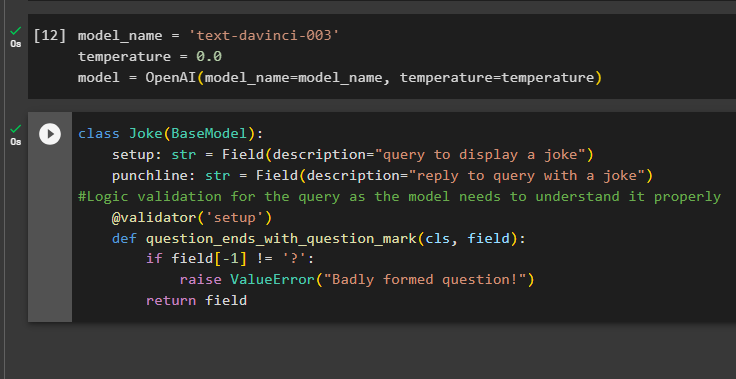

Construire la structure de la sortie est l’application vitale des analyseurs de sortie dans les grands modèles linguistiques. Avant d'aborder la structure des données des modèles, il est nécessaire de définir le nom du modèle que nous utilisons pour obtenir la sortie structurée des analyseurs de sortie :

température = 0,0

modèle = OpenAI ( nom du modèle =nom_modèle, température =température )

Maintenant, utilisez la classe Joke contenant le BaseModel pour configurer la structure de la sortie afin d'obtenir la blague du modèle. Après cela, l'utilisateur peut facilement ajouter une logique de validation personnalisée avec la classe pydantic qui peut demander à l'utilisateur de placer une requête/invite mieux formée :

blague de classe ( Modèle de base ) :configuration : str = Champ ( description = 'requête pour afficher une blague' )

punchline : str = Champ ( description = 'Répondre à la requête avec une blague' )

#Validation logique de la requête car le modèle doit la comprendre correctement

@ validateur ( 'installation' )

def question_ends_with_question_mark ( cls, champ ) :

si champ [ - 1 ] ! = '?' :

augmenter ValueError ( 'Question mal formulée !' )

retour champ

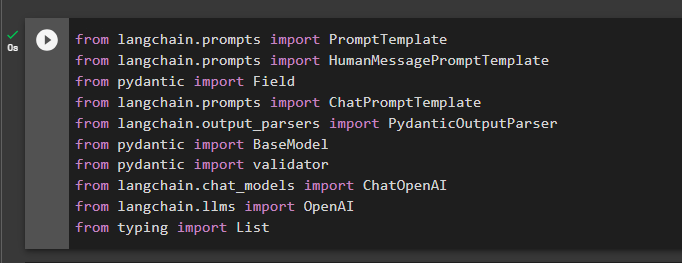

Étape 4 : Définition du modèle d'invite

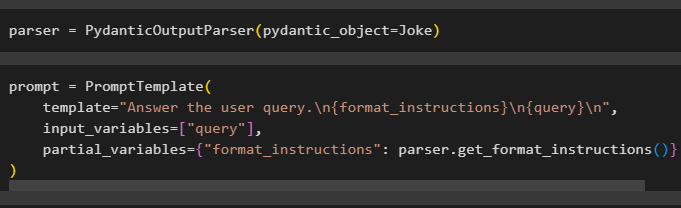

Configurez la variable d'analyseur contenant la méthode PydanticOutputParser() contenant ses paramètres :

Après avoir configuré l'analyseur, définissez simplement la variable d'invite à l'aide de la méthode PromptTemplate() avec la structure de la requête/invite :

invite = Modèle d'invite (modèle = 'Répondez à la requête de l'utilisateur. \n {format_instructions} \n {requête} \n ' ,

variables_d'entrée = [ 'requête' ] ,

variables_partielles = { 'format_instructions' : parser.get_format_instructions ( ) }

)

Étape 5 : tester l'analyseur de sortie

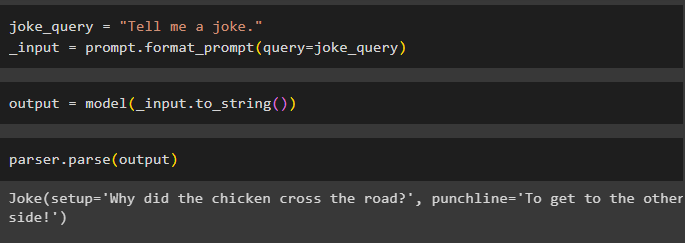

Après avoir configuré toutes les exigences, créez une variable affectée à l'aide d'une requête, puis appelez la méthode format_prompt() :

_input = prompt.format_prompt ( requête =blague_requête )

Maintenant, appelez la fonction model() pour définir la variable de sortie :

sortie = modèle ( _input.to_string ( ) )Terminez le processus de test en appelant la méthode parser() avec la variable de sortie comme paramètre :

analyseur.parse ( sortir )

Il s’agit du processus d’utilisation de l’analyseur de sortie dans LangChain.

Conclusion

Pour utiliser l'analyseur de sortie dans LangChain, installez les modules et configurez l'environnement OpenAI à l'aide de sa clé API. Après cela, définissez le modèle puis configurez la structure des données de la sortie avec validation logique de la requête fournie par l'utilisateur. Une fois la structure de données configurée, définissez simplement le modèle d'invite, puis testez l'analyseur de sortie pour obtenir le résultat du modèle. Ce guide a illustré le processus d'utilisation de l'analyseur de sortie dans le framework LangChain.